Cloud Computing und seine Möglichkeiten

Die Nutzung der Cloud erhält eine neue Dimension, wenn es gelingt, den gesamten Geschäftsprozess von der Bestellung bis zur Verwaltung von Server-Instanzen automatisiert abzubilden

Bei der Public Cloud befinden sich die Ressourcen bei einem Provider, welcher über das Internet angebunden ist. Die Infrastruktur wird dann komplett als as-a-Service eingekauft

Von Michael Kyau und Axel Friedrich (*)

(11.05.12) - Software-as-a-Service, Plattform-as-a-Service und Infrastruktur-as-a-Service können über verschiedene Infrastrukturvarianten, die Public Cloud, die Virtual Private Cloud und die Private Cloud bereitgestellt werden. Auf Cloud Computing spezialisierte Firmen helfen dabei, diese drei Varianten bei Kunden ein zu binden, um deren explizite Vorteile vergleichbar und verfügbar zu machen.

Die in der Cloud geschaffenen Strukturen können dynamisch an die Erfordernisse von Geschäftsprozessen angepasst werden, diese komplett betrieben und gemanagt werden. Ziel ist es, das magische Tripple: Zeit, Kosten und Prozesse für den Anwender bei hoher Flexibilität und Skalierung zu optimieren. Um die Vorteile der Cloud zusätzlich herauszuheben, bedarf es bei der Bereitstellung und der Verwaltung der Instanzen eines hohen Automatisierungsgrades. In letzter Konsequenz führt dieser hohe Automatisierungsgrad zu einer effizienten Nutzung von humanen, physischen und immateriellen Ressourcen. Ein typischer Provider solcher Services ist die Amazon Elastic Compute Cloud (Amazon EC2).

Cloud Computing wird in unterschiedliche Services wie "Software-as-a-Service" – SaaS, "Plattform-as-a-Service" – PaaS und "Infrastruktur-as-a-Service" – IaaS unterteilt.

>> Die erste Unterteilung "Software-as-a-Service" sagt aus, dass die Applikationen vollständig in der Cloud laufen. Der Endkunde ist der Nutzer, wobei der Zugriff auf die Anwendung über den Browser erfolgt. Ein Beispiel hierfür ist salesforce.com.

>> Die zweite Unterteilung ist "Plattform as a Service". Hier wird eine integrierte Laufzeitumgebung (und evtl. auch Entwicklungsumgebung) als ein Dienst zur Verfügung gestellt. Es wird nur bei Nutzung des Services bezahlt. Bekannte Beispiele dafür sind Google App Engine und Windows Azure.

>> "Infrastruktur as a Service" als Drittes ist die Grundlage der Cloud (Wolke) - eine Art virtuelle Infrastruktur und dient als Kernpunkt der nachfolgenden Betrachtungen.

Bei IaaS stellen Firmen ihre überschüssige Rechenleistung in Form von virtuellen Servern (Instanzen) zur Verfügung. Durch diese dynamische Nutzungsmöglichkeit verschenken die Unternehmen keine Rechenleistung und können mit ihren Überkapazitäten Geld verdienen. Vorreiter auf diesem Gebiet und Anbieter von IaaS sind Amazon Web Service (AWS) und Cloud Computig-Lösungen von Salesforce sowie IBM. Instanzen werden bei Amazon über das AMI (Amazon Machine Image) beschrieben, welche das Betriebssystem und die Applikation beinhalten. Das AMI kann als eine Festplatte verstanden werden, von welcher das System gestartet werden kann. Bei Start dieses AMIs wird dann die Größe hinsichtlich RAM, CPU und Zusatzspeicher des Servers festgelegt.

"Cloud Computing" steht für einen Pool aus abstrahierter, hochskalierbarer und verwalteter IT-Infrastruktur, die Kundenanwendungen vorhält und falls erforderlich nach Gebrauch abgerechnet werden kann. (Quelle: Forrester Research)

Die oben aufgeführten Services können über verschiedene Infrastrukturvarianten, die Public Cloud, die Virtual Private Cloud und die Private Cloud bereitgestellt werden.

Auf Cloud Computing spezialisierte Firmen helfen dabei, diese drei Varianten bei Kunden ein zu binden, um deren explizite Vorteile vergleichbar und verfügbar zu machen.

Bei der Public Cloud befinden sich die Ressourcen bei einem Provider, welcher über das Internet angebunden ist. Die Infrastruktur wird dann komplett als "as is" Service eingekauft. Üblicherweise ist dies die am Schnellsten einzubindende Variante, welche allerdings nicht für sicherheitskritisch einzustufende Produktionssysteme zu favorisieren ist. Durch entsprechende Sicherheitskonzepte, in deren Ergebnis eine Matrix mit Anforderungen an die Sicherheitsstufen entsteht, ist bei deren Umsetzung die Verwendung einer Vielzahl an Applikationen dennoch möglich.

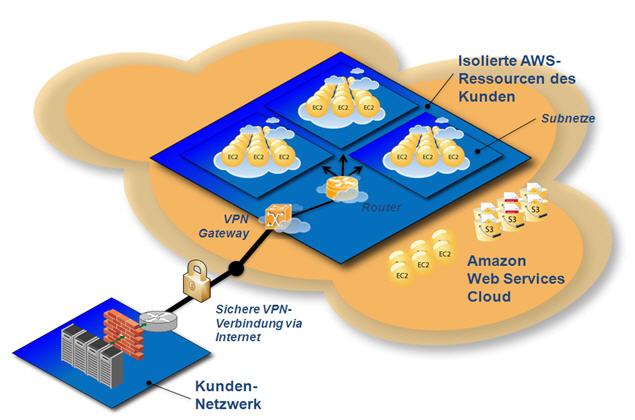

Für Produktionssysteme mit streng vertraulichen Daten empfiehlt sich der Einsatz der zweiten Infrastrukturvariante, der Virtual Private Cloud (VPC). Hier ist der Provider ebenfalls über das Internet angebunden, jedoch erfolgt die Kommunikation über einen Virtuell Privat Network (VPN Tunnel), die virtuelle Infrastruktur befindet sich beim Provider in einer eigenen Umgebung (Netzsegment). Auch hier wird die Infrastruktur komplett als Service eingekauft. Auf der Seite des Kundennetzwerks muss die eigene Firma die Infrastruktur (VPN-Gateway, Firewall, Netzwerk, Server usw.) und Administration der VPN Verbindung bereitstellen. Es entstehen daher Extrakosten. Die VPC stellt eine "Verlängerung" des eigenen Firmennetzes dar.

Für den Einsatz sicherheitskritischer Systeme existiert eine dritte Möglichkeit: die Private Cloud. Die Infrastruktur für die Privat Cloud befindet sich "im eigenen Haus", wobei die Bereitstellung, Administration und die Kosten von der eigenen Firma selbst getragen werden.

Im Rahmen eines Großkundenprojektes kommt als Cloud-Umgebung die Open Source-Lösung "Eucalyptus Cloud", von der Canonical Group, auf Basis von Ubuntu und die Enterprise Cloud 2.0 zum Einsatz. Ausschlaggebend für den Einsatz dieser Cloud-Varianten ist, dass sie die gleichen Schnittstellen zur Steuerung wie Amazon Webservices bieten. Es können daher In House Applikationen entwickelt und getestet werden, welche dann zum produktiven Einsatz nach Amazon überführt werden können.

Die Absicherung und der Betrieb von virtuellen Systemen, unabhängig ob diese in einer Private- oder Public Cloud betrieben werden, lassen sich nach dem Prinzip zusammenfassen: Die virtualisierten Systeme müssen so betrieben und abgesichert werden, als wären sie interne Systeme. Definierte Anwendungsfälle dienen als Basis für eine abstrakte Risikoidentifizierung und Risikobewertung gegenüber typischen Cloud Computing-Risiken.

Die Erstellung eines Sicherheitskonzepts für den Betrieb von Unternehmensanwendungen in der Cloud ist erforderlich. Damit erfolgt die sicherheitstechnische Einstufung der Unternehmensanwendungen. So kann ein Ergebnis sein, dass eine Anwendung aufgrund von Sicherheitsaspekten wie dem Datenschutzgesetz nicht in der Cloud eingesetzt werden kann. Zum anderen werden Lösungsmöglichkeiten, wie Verschlüsselung der Daten und entsprechend dafür nutzbare Werkzeuge angeboten, um entsprechende Risiken zu senken oder auszuräumen.

Ein weiterer Betrachtungspunkt ist die Cloud-Performance. Diese ist für die virtuellen Systeme theoretisch unbegrenzt und wird vom Dienstanbieter durch eine nicht näher spezifizierte Cloud (Wolke) erbracht. Die möglichen Hardware-Konfigurationen für die Server-Instanzen werden durch den Dienstleister definiert und bereitgestellt.

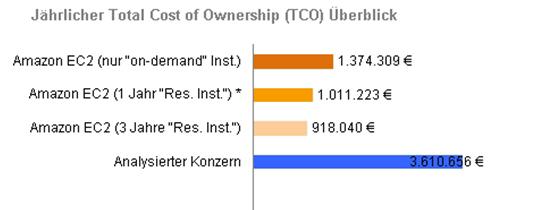

Im Folgenden wird eine repräsentative Kostenanalyse durchgeführt, um die Einsparungen aus kaufmännischer Sicht an einem Beispiel zu verdeutlichen.

Als Berechnungsgrundlage dient ein Mischbetrieb mit 1000 Servern. Hierbei werden 300 Server, welche hauptsächlich dem Abfangen von Lastspitzen dienen sollen, mit einer Nutzung von 20 Prozent im Jahr und die restlichen 700 Server in unterschiedlicher Konfiguration im Dauerbetrieb herangezogen. Diese 1000 Server können auch, wie folgend dargestellt, im Voraus für 1 Jahr oder 3 Jahre bestellt und bezahlt werden (reservierte Instanzen). Durch die somit signifikant reduzierten Stundensätze wird der Preis günstiger. Eine weitere Möglichkeit wäre die 700 von den 1000 Servern als reservierte Instanz im Voraus zu kaufen und die restlichen 300 Server bei Bedarf (on-demand) zu betreiben.

Abbildung 2 beschreibt eine repräsentative Kostenkalkulation. Man erkennt, dass durch den Einsatz von Cloud Instanzen eine Ersparnis von knapp 62 Prozent ("On demand Instances") bis zu 75 Prozent ("3 Jahre Reserved Instances") gegenüber den analysierten Konzernkosten verbucht werden können. Dabei ist zu beachten, dass die Mehrkosten für die Administration nicht enthalten sind, so dass die Kosteneinsparungen real höher ausfallen können.

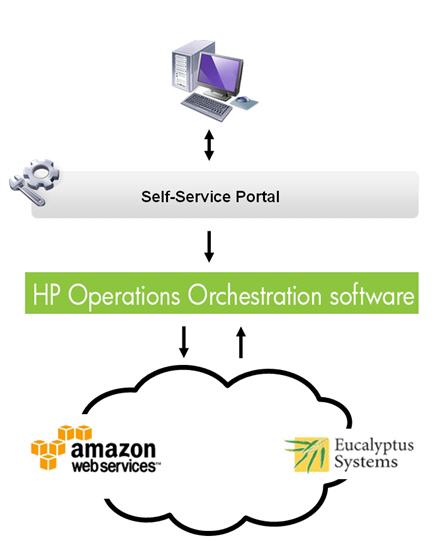

Die Nutzung der Cloud erhält eine neue Dimension, wenn es gelingt, den gesamten Geschäftsprozess von der Bestellung bis zur Verwaltung von Server-Instanzen automatisiert abzubilden. Die Vorteile des Cloud Computing wie Kosteneinsparung, Agilität in der Bereitstellung und der Darstellung von Geschäftsprozessen werden durch diesen Automatisierungsschritt besonders greifbar. Ziel ist es, dass Mitarbeiter des Unternehmens diese Bereitstellung und Verwaltung von Server-Instanzen unternehmenskonform, innerhalb weniger Minuten bei minimalem Administrationsaufwand durchführen können.

Neben der eigentlichen Entwicklung dieser automatisierten Bereitstellung besteht die Herausforderung darin, die bereits im Unternehmen genutzten Werkzeuge und die damit verbundenen Prozesse mit dieser Lösung zu koppeln. Innerhalb eines konkreten Kundenprojektes wurden für die Umsetzung verschiedene Komponenten verwendet: Ein Self-Service Portal, HP Operations Orchestration (HP OO) sowie die Amazon / Eucalyptus Web Services Application Programmer Interface (API).

Das Self-Service Portal ist ein auf Basis von Java entwickeltes Frontend für die Interaktion mit dem Mitarbeiter. "HP OO" aus dem "HP Business Technology Optimization" (HP BTO)-Portfolio ermöglicht es, mit seiner Vielzahl an Schnittstellen, im Unternehmen etablierte Werkzeuge und Komponenten, durch kontrollierte und zeitlich festgelegte Aufrufe in einem neuen Prozess zusammenzufassen. Hierfür werden so genannte Flows generiert, welche die einzelnen Teilprozesse aufrufen.

Die Amazon / Eucalyptus API dient als Schnittstelle, um die tatsächlichen Steuerprozesse an die Infrastrukur bei Amazon oder Eucalyptus zu übergeben.

Die Umsetzung der Ziele mittels dieser Komponenten erfolgt konkret über Eingaben des Mitarbeiters in der Web-Anwendung (Self-Service Portal). Dieses ermöglicht es den Mitarbeitern, Server-Instanzen mit einer bestimmten Konfiguration, in Form von Hardware und Software, zu bestellen. Hierbei wird eine monatliche Hochrechnung der Kosten, welche bei Dauernutzung der Instanz anfallen würden, visualisiert.

Außerdem kann der Mitarbeiter die für Ihn bereitgestellten Instanzen mit Standardverfahren wie Start, Stopp und Restart, selbstständig verwalten.

Um die Kosten für bereits bestellte Server-Instanzen offen zu legen, sind Abrechnungen für die bestellten Instanzen über das Portal jederzeit abrufbar und einsehbar.

Die Eingaben in das Self-Service Portal (Frontend) werden an HP OO übergeben. In der Folge wird ein Flow gestartet, welcher beispielsweise einzelne Aufgaben wie das Starten einer Instanz und dem anschließenden Versand einer Email an den Mitarbeiter verwirklicht. HP OO stellt somit die operative Ausführungsschicht dar.

Ein realisiertes Beispiel für den Geschäftsprozess aus einer Hand ist der Einsatz von Lastgeneratoren in der Amazon Public Cloud. Mittels des Portals und der einhergehenden automatisierten Bestellung können LoadRunner Instanzen, unabhängig von Anzahl und Setup, sehr schnell bereitgestellt werden.

Der HP LoadRunner dient zum Erstellen einer exakten Analyse der End-to-End Systemperformance. Dabei wird, zum Beispiel im Rahmen von Integrationstests, überprüft, ob neue oder aktualisierte Applikationen Ihre Performanceanforderungen erfüllen. Es werden Performanceengpässe während des gesamten Entwicklungslebenszyklus identifiziert und eliminiert, und Produktionsausfallzeiten reduziert.

Im Amazon Web Service Cloud Computing-Umfeld wurde hierfür ein AMI (Amazon Machine Image) gestartet. Im Anschluss wurde LoadRunner installiert, konfiguriert und das Netzsetup vorgenommen.

Aus diesem Basisimage wurde ein neues AMI erstellt und in Amazon verfügbar gemacht. Dieses AMI kann jetzt in mehreren Instanzen gleichzeitig gestartet werden. Nach dem Start werden die Instanzen für Lasttests aus dem Internet gegen zu testende Webseiten des Kunden gefahren.

Ein ähnliches Vorgehen erfolgt bei dem Einsatz von Instanzen mit dem Tool HP Business Availability Center (BAC). BAC bietet effizientere, an den Unternehmenszielen ausgerichtete ITSM Prozesse für den Umgang mit Vorfällen und Problemen, messbare Risiken und Auswirkungen auf den Geschäftsbetrieb aus der Perspektive des Endbenutzers, proaktives Management von geschäfts- und betriebsorientierten Service Levels, beschleunigte Problemisolierung durch automatisierte Standardprozesse im Betrieb, Management von komplexen Geschäftstransaktionen in heterogenen Umgebungen und Management der Komplexität von gemischten Applikationen und SOA.

Hierfür wurde ein BAC Agent auf das AMI installiert und gestartet. Der Einsatz erfolgt hauptsächlich als End to End Monitoring für aus dem Internet erreichbare Kundenseiten. Desweiteren können über Trigger auch wieder automatisierte Workflows in HP OO angesteuert werden.

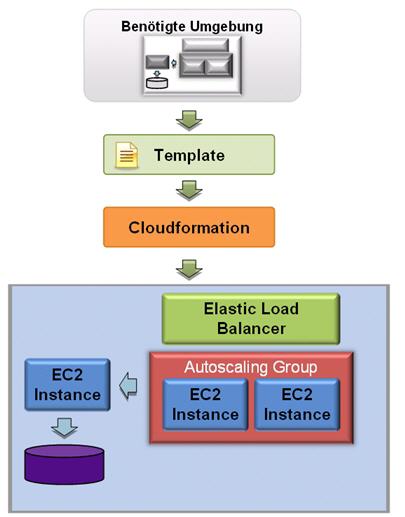

Die nächste Stufe stellt den Übergang von IaaS zu PaaS dar. Dabei steht insbesondere die Bereitstellung von komplexen Umgebungen im Fokus (n-Tier Architekturen).

Amazon Webservices bietet für diesen Bereich den Dienst Cloud Formation, welcher Entwicklern und Systemadministratoren die Möglichkeit bietet, eine Sammlung von zugehörigen AWS-Ressourcen mit geringem Aufwand zu erstellen und zu verwalten. Die EC2 Ressourcen(beispielsweise Instanzen, Security Groups, Load Balancer) werden zu einer Umgebung zusammengefasst um in einer geordneten Abarbeitungsfolge bereitgestellt und bekannt gemacht.

Die nachfolgende Abbildung beschreibt ein einfaches Beispiel einer Umgebung - zwei Anwendungsserver, welche Load-Balanced werden und auf eine Datenbank-Instanz zugreifen.

Hervorzuheben ist, dass die Anwendungsserver in einer Autoscaling Group gehalten werden. Dies ist ein weiterer Dienst von Amazon Webservices, welche das automatische (De-) Provisionieren von Instanzen ermöglicht. Bei der Überschreitung von definierbaren Schwellwerten werden demnach neue Instanzen erstellt und der Umgebung hinzugefügt, bei Unterschreitung von Schwellwerten Instanzen abgeräumt. Dieses Vorgehen ist sehr effektiv um kurzzeitige Lastspitzen einfach und effektiv abzufangen.

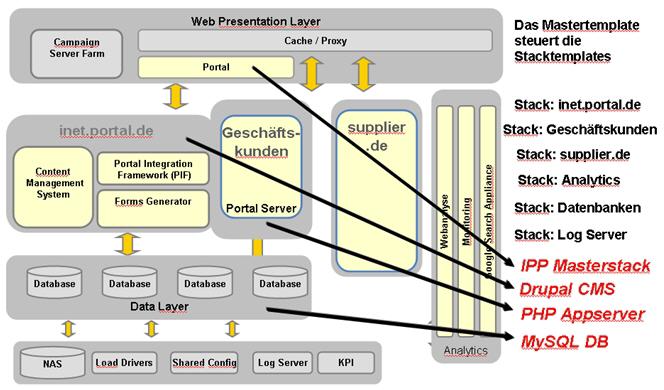

Für sehr komplexe Umgebungen empfiehlt sich die Defintion von Modulen über Master-Templates. Nachfolgende Abbildung beschreibt ein solches Konstrukt für eine komplexe Umgebung, in Form einer Internetplattform.

Der Web Presentation Layer wird über ein Mastertemplate definiert. Das Mastertemplate stellt die modulare Struktur dar. Die einzelnen Module sind Verweise auf andere Templates welche wiederum ganze Umgebungen beschreiben. Angesteuert wird das Mastertemplate. Mit diesem können auch Parameter an die Sub-Templates übergeben oder ausgelesen werden. Jedes der Templates kann alle Services (z.B. RDS, EBS, Autoscaling, Loadbalancing …), welche von Amazon zur Verfügung gestellt werden, nutzen.

Die profi.com AG bietet im Bereich des Cloud Computing ein großes Spektrum an Dienstleitungen an. Wir analysieren die Kosten und den Nutzen des Einsatzes von Cloud-Systemen in Abhängigkeit Ihrer Unternehmensstruktur und dem angestrebten Einsatzweck. Zugleich führen wir Tests (z.B. Lasttests) Ihrer Applikationen für den Einsatz, sowie Untersuchungen nach der Erfüllung der Sicherheitseinstufung Ihrer Anwendungen in der Cloud durch.

Diese Maßnahmen führen zu einer optimalen Konzeption der für Sie prädestinierten Cloud-Systeme.

Nach der Inbetriebnahme der Cloud bieten wir Administrationsleistungen an. Auf Wunsch automatisieren wir die mit Cloud Computing, sowie anderer Themenbereiche, einhergehenden Prozesse, speziell abgestimmt auf ihre Unternehmensstruktur.

Profitieren auch Sie als Kunde von unserem Technik- und Prozess Know-how und erreichen Sie eine hohe Einsparung in dem Betrieb ihrer Services im Unternehmen.

Die Autoren

Axel Friedrich wurde 1968 in Dresden geboren. Er ist seit 1992 in der Informationstechnik und seit Mai 2009 für verschiedene Großkunden im Bereich Cloud Computing aktiv. Er ist Consultant in mehreren Projekten im Bereich Automatisierung IT-Architektur sowie Cloud Computing.

Michael Kyau wurde 1984 in Löbau geboren. Er studierte Informatik an der Hochschule Zittau / Görlitz und ist seit April 2009 Mitarbeiter der profi.com AG. Seitdem ist er als IT-Consultant in mehreren Projekten im Bereich Server-, Client- und Prozess-Automatisierung sowie Cloud Computing tätig.

(profi.com AG business solutions: ra)

profi.com: Kontakt und Steckbrief

Der Informationsanbieter hat seinen Kontakt leider noch nicht freigeschaltet.